AI modely stále „halucinujú“. Nová štúdia odhalila nepríjemnú pravdu

Popredné modely generatívnej umelej inteligencie vrátane GPT-4o a Google Gemini často vytvárajú nepravdivé informácie, tvrdí nová štúdia. Čo je dôvodom tohto problému a ako ho vyriešiť?

Výskumníci z Cornellovej univerzity a ďalších inštitúcií skúmali presnosť modelov generatívnej umelej inteligencie v rôznych témach. Zistili, že ani jeden model nie je spoľahlivý vo všetkých testovaných oblastiach. Aj tie najlepšie modely v skutočnosti dokázali poskytnúť naozaj spoľahlivé informácie len približne v 35 % prípadov.

Prečo si umelá inteligencia vymýšľa?

Zo štúdie vyplynulo, že hlavnou príčinou je časté vytváranie odpovedí na otázky, na ktoré modely nepoznajú správnu odpoveď. Týka sa to aj najnovších modelov ako GTP-4o.

Štúdia takisto ukázala, že odpovede, ktoré sú fakticky nesprávne, vznikajú častejšie pri témach, kde sa AI modely nemôžu oprieť o údaje z Wikipédie. Najväčšie problémy majú modely s otázkami o celebritách a financiách, zatiaľ čo s témami ako geografia či počítačová veda si vedia poradiť lepšie.

Nie je to pritom jediná štúdia, ktorá prichádza s podobnými zisteniami. Nie je to tak dávno, čo výskumníci z Glasgowskej univerzity označili tento neduh tvrdším výrazom – „soft bullshit“:

ChatGPT isn't hallucinating, it's spreading "soft bullshit"!

Researchers from Glasgow University propose that misleading outputs from LLMs be termed "bullshit" rather than "hallucinations."

Their study draws on philosopher Harry Frankfurt's definition of bullshit, which…

— Tau (@TauLogicAI) June 18, 2024

Ako tento problém vyriešiť?

Zaujímavým zistením je, že lepšie výsledky v tomto výskume vykázali modely, ktoré odmietali odpovedať na neznáme otázky. Príkladom takéhoto modelu je Claude 3 Haiku. Podľa výskumníčky Wenting Zhao však môže používateľov odrádzať, ak často nedostanú odpoveď na svoju otázku.

Podľa Zhao sú riešením problému s halucináciami pokročilé nástroje na overovanie faktov a zapojenie ľudských expertov do procesu vývoja AI.

Najdôležitejším zistením však nateraz zostáva, že na odpovede od umelej inteligencie sa stále nemožno plne spoľahnúť a treba si ich overovať, keďže problém „halucinovania“ umelej inteligencie zrejme len tak skoro nevymizne.

Upozornenie pre použivateľov

Rovnako tak si treba pri generovaní odpovedi cez chatboty, ako sú ChatGPT, Claude či Gemini, ale aj iných, uvedomiť, že určité percento odpovedí (približne 10%) nie je pravdivé, respektíve 100% správne. Každým ďalším dotazom na rovnakú tému sa však pravdepodobnosť správneho finálneho výstupu znižuje. Platí teda, že AI je dobrý sluha, ale zlý pán. Inak povedané môže ušetriť čas, respektíve urýchliť prácu, no výstupy z chatbotov súčasnej generácie treba overovať a prípadne opraviť, ak sa zmýlia.

Zdroj: TechCrunch, Autor

Najčítanejšie články

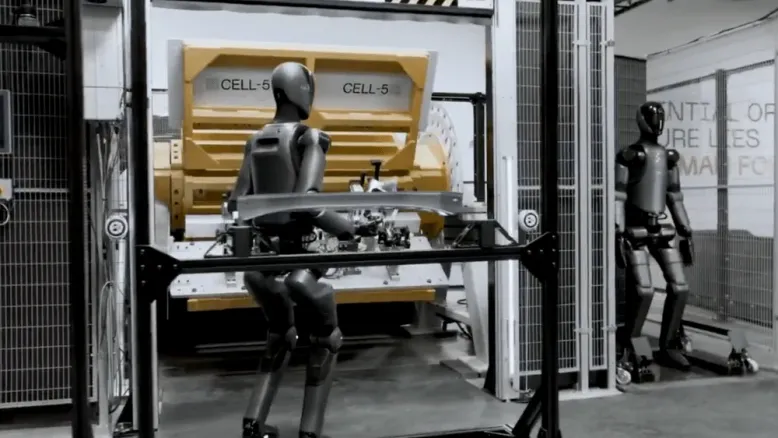

VIDEO: Humanoidy Figure 02 začali pracovať vo fabrike BMW

21. novembra 2024

SpaceX uskutočnila šiesty let rakety Starship - tentokrát nedopadol podľa predstáv

21. novembra 2024

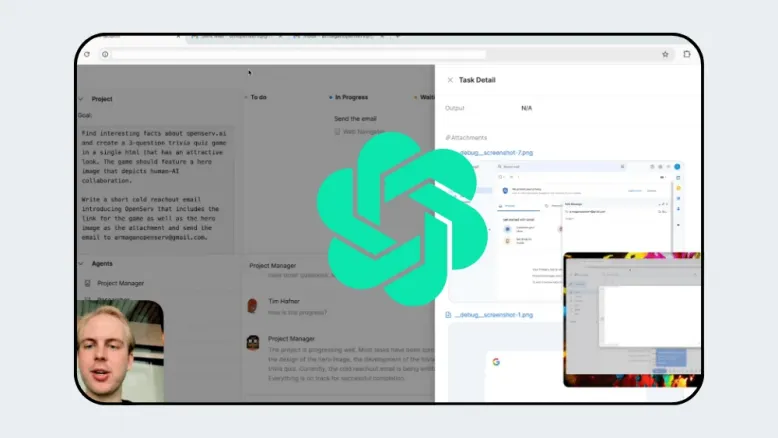

OpenAI chystá revolučného AI agenta na ovládanie počítača

20. novembra 2024

Meta AI dorazila do prvých európskych krajín – v okuliaroch Ray-Ban Meta

20. novembra 2024