Je ChatGPT-4o nebezpečný pre ľudstvo? OpenAI zverejnila výsledok analýzy

Spoločnosť OpenAI zverejnila správu o hodnotení bezpečnosti modelu GPT4-o pred jeho sprístupnením pre verejnosť. Model podľa nej predstavuje stredne veľké riziko.

Spoločnosť OpenAI nedávno zverejnila výsledky bezpečnostnej kontroly najnovšej verzie svojho jazykového modelu GPT-4o. Táto správa poskytuje komplexný prehľad o tom, aké bezpečnostné výzvy prináša model GPT-4o. Zároveň naznačuje, aké kroky plánuje OpenAI podniknúť, aby minimalizovala potenciálne škody.

Čo odhaľuje bezpečnostná správa?

Pred májovým uvedením modelu GPT-4o spoločnosť OpenAI zaangažovala externých bezpečnostných expertov, ktorí mali v spolupráci s jej interným tímom odhaliť slabé miesta systému.

Zamerali sa na oblasti, ako sú dezinformácie, neetické používanie technológie či ochrana osobných údajov. Spoločnosť OpenAI poskytla svoj vlastný hodnotiaci rámec a podľa jeho výsledkov systém predstavuje stredne veľké riziko.

Jedným z kľúčových problémov je nebezpečenstvo, že GPT-4o dokáže ovplyvniť názory čitateľov výraznejším spôsobom, ako ľudia. Vplyvom toho sa dá zneužiť na vytváranie dezinformácií, čo môže mať ďalekosiahle následky na spoločnosť.

Medzi ďalšie hrozby patria tvorba neautorizovaných replík hlasu a reprodukovanie chráneného obsahu. Ostatné kategórie, ako kybernetická bezpečnosť a biologické hrozby, boli klasifikované ako nízkorizikové.

We’re sharing the GPT-4o System Card, an end-to-end safety assessment that outlines what we’ve done to track and address safety challenges, including frontier model risks in accordance with our Preparedness Framework. https://t.co/xohhlUquEr

— OpenAI (@OpenAI) August 8, 2024

Ako sa OpenAI snaží znížiť riziká?

Spoločnosť OpenAI tvrdí, že neustále pracuje na tom, aby znížila potenciálne nebezpečenstvo spojené s používaním modelov GPT. Zameriava sa napríklad na vývoj mechanizmov, ktoré by dokázali lepšie identifikovať a blokovať škodlivé použitie modelov. Takisto spolupracuje s odborníkmi na etiku a bezpečnosť s cieľom zaistiť, aby sa modely používali zodpovedne.

Podobné správy ako teraz zverejnila spoločnosť aj v minulosti v súvislosti so staršími modelmi. Táto správa však prichádza pred americkými prezidentskými voľbami, teda v čase, ktorý je obzvlášť náchylný na rôzne manipulácie a dezinformácie. Spoločnosť OpenAI pritom čelí neustálej kritike svojich bezpečnostných štandardov zo strany odborníkov aj politikov. Napriek ich tlaku je dôležité, aby sa aj používatelia sami stavali k modelom umelej inteligencie bezpečne, overovali si informácie, mysleli kriticky a nedali sa manipulovať.

Zdroj: The Verge

Najčítanejšie články

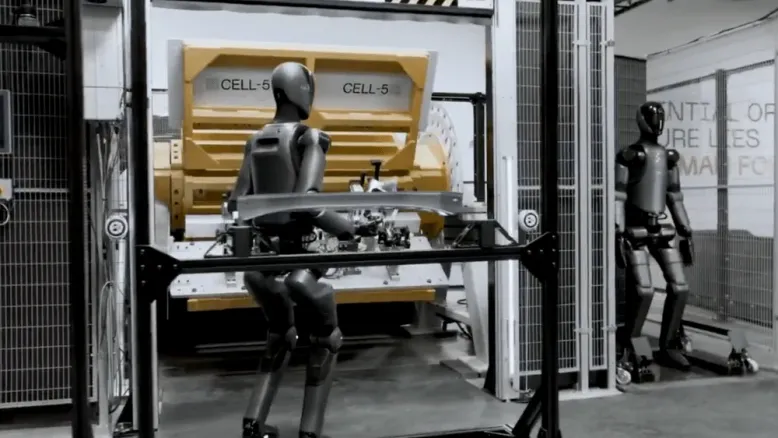

VIDEO: Humanoidy Figure 02 začali pracovať vo fabrike BMW

21. novembra 2024

SpaceX uskutočnila šiesty let rakety Starship - tentokrát nedopadol podľa predstáv

21. novembra 2024

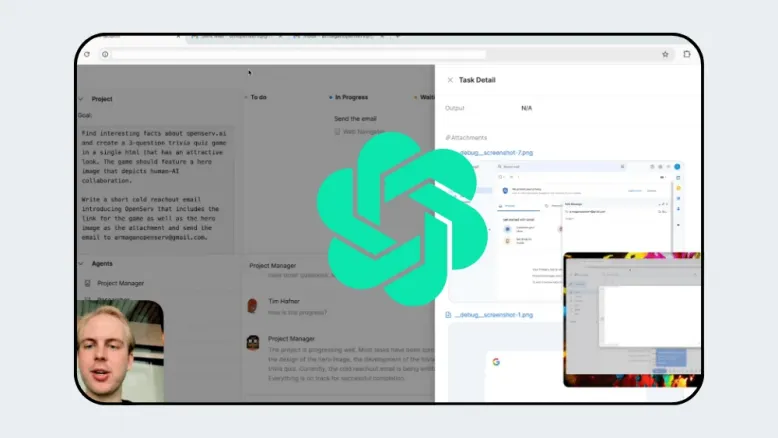

OpenAI chystá revolučného AI agenta na ovládanie počítača

20. novembra 2024

Meta AI dorazila do prvých európskych krajín – v okuliaroch Ray-Ban Meta

20. novembra 2024